| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- 지표

- 논문 정리

- github

- 청첩장 모임

- study

- 14일 공부

- amazon ecs

- AWS

- 티스토리챌린지

- 실용주의 프로그래머

- DevOps

- AWS 비용 절감

- Go-lang

- 생성 패턴

- 커머스

- Til

- docker

- PostgreSQL

- 디자인 패턴

- Rust

- 오블완

- Playwright

- leetcode

- 회고

- 경로 계획 알고리즘

- 신혼 여행

- terraform

- 구조 패턴

- ssh

- MAPF

- Today

- Total

밤 늦게까지 여는 카페

AI 엔지니어링 스터디 #2 - 파운데이션 모델 이해하기 본문

Q1. 언어 모델에서 말하는 token과 vocabulary는 뭐야? 실제 단어랑 어떻게 달라?

A.

- Token은 모델이 실제로 처리하는 최소 단위

- Vocabulary는 모델이 인식할 수 있는 모든 토큰의 집합

- 토큰은 우리가 말하는 "단어"와 1:1 대응하지 않습니다.

예시

- 문장:

나는 학교에 갔다 - 단어 기준:

["나는", "학교에", "갔다"] - 토큰 기준:

["▁나", "는", "▁학교", "에", "▁갔", "다"]

=> 토큰은 단어보다 작거나, 경우에 따라 더 큰 단위가 될 수도 있습니다.

Q1.1. 모델이 학습하지 못한 이상한 단어를 쓰면 어떻게 돼?

A.

요즘 LLM은 서브워드 토큰화를 사용해서 그런 문제가 발생하지 않습니다.

예시

- 입력:

핫초코맛치킨 - 토큰화:

["핫", "초코", "맛", "치킨"]

=> 단어 전체를 몰라도 구성 요소 단위로 쪼개서 의미를 추론합니다.

Q1.2. 서브워드 토큰화를 했는데도 vocabulary에 없으면요?

A.

그냥 문자(혹은 바이트) 단위로 토큰화 되기 때문에 문제가 없습니다.

예시

- 입력:

꿼쀐쮌휈뛠 - 토큰화:

["꿼", "쀐", "쮌", "휈", "뛠"]

Tokenization의 자세한 구현이 궁금하다면 다음 내용을 참고하실 수 있습니다.

Q2. Masked Language Model(MLM)과 Auto-Regressive Model(AR)은 어떻게 달라?

A.

- MLM (예: BERT)

- 문장 일부를 가리고([MASK]) 맞히는 방식

- 양쪽 문맥을 모두 사용

- 주로 "이해" 중심 작업에 강함

- AR (예: GPT)

- 이전 토큰들을 보고 다음 토큰을 예측

- 한 방향(왼쪽 → 오른쪽)

- 텍스트 생성에 특화

예시

- MLM:

나는 [MASK]에 갔다 → 학교 - AR:

나는 학교에 → 갔다

Q3. 언어 모델이 자기 지도 학습(Self-supervised learning)이 가능한 이유는?

A.

텍스트 자체가 입력과 정답을 동시에 제공하기 때문이다.

- 입력: 이전 토큰들

- 정답: 다음 토큰

사람이 별도의 라벨을 달지 않아도 "다음 토큰 예측"이라는 형태로 스스로 학습 신호를 만들 수 있습니다.

예시

- 원문:

텍스트 자체가 입력과 정답을 동시에 제공하기 때문이다. - 학습용 입력:

텍스트 자체가 **입력과 정답을 동시에 제공**하기 - 학습용 정답:

때문이다.

Q4. 파운데이션 모델이 뭐에요? 언어 모델과 어떻게 다른 거에요?

A.

앞서 공부했던 언어 모델은 언어의 통계 정보를 다루는 모델입니다.

마르코프 체인, 정보 이론, 통계학적 언어 모델, 형식 언어 이론 등 1910년대부터 연구되었습니다.

그러다가 2018년 6월 오픈AI의 첫번째 생성형 사전 학습 트랜스포머(GPT) 모델이 1억 1,700만 개의 파라미터를 선보이면서 대규모 언어 모델이라는 용어가 나왔습니다.

대규모 언어 모델이 널리 사용되면서 이미지, 음성, 동영상 등 다양한 데이터 모달리티(형식)을 지원하게 되었고 이를 대규모 멀티모달 모델이라고 칭했습니다.

파운데이션 모델은 대규모 언어 모델과 대규모 멀티모달 모델을 모두 지칭하는 용어로 사용됩니다.

Q5. 파운데이션 모델에서 "토큰화"는 모델 안에서 일어나는 거야?

A.

의미에 따라 다릅니다.

텍스트

- 토큰화는 모델 밖 전처리 단계

- 텍스트 → 토큰 ID → 임베딩 → Transformer

이미지·영상·오디오

- 토큰화는 단순 전처리가 아니라 입력을 Transformer가 처리할 수 있는 토큰 시퀀스로 변환하는 과정

- 보통 모델 앞단의 인코더(ViT 등) 가 담당

모달리티별로 인코더를 둔다는 것이 핵심입니다.

- 텍스트 → 토큰

- 이미지 → 패치 토큰

- 영상 → 프레임/패치 토큰

이렇게 통일된 형태로 Transformer에 입력합니다.

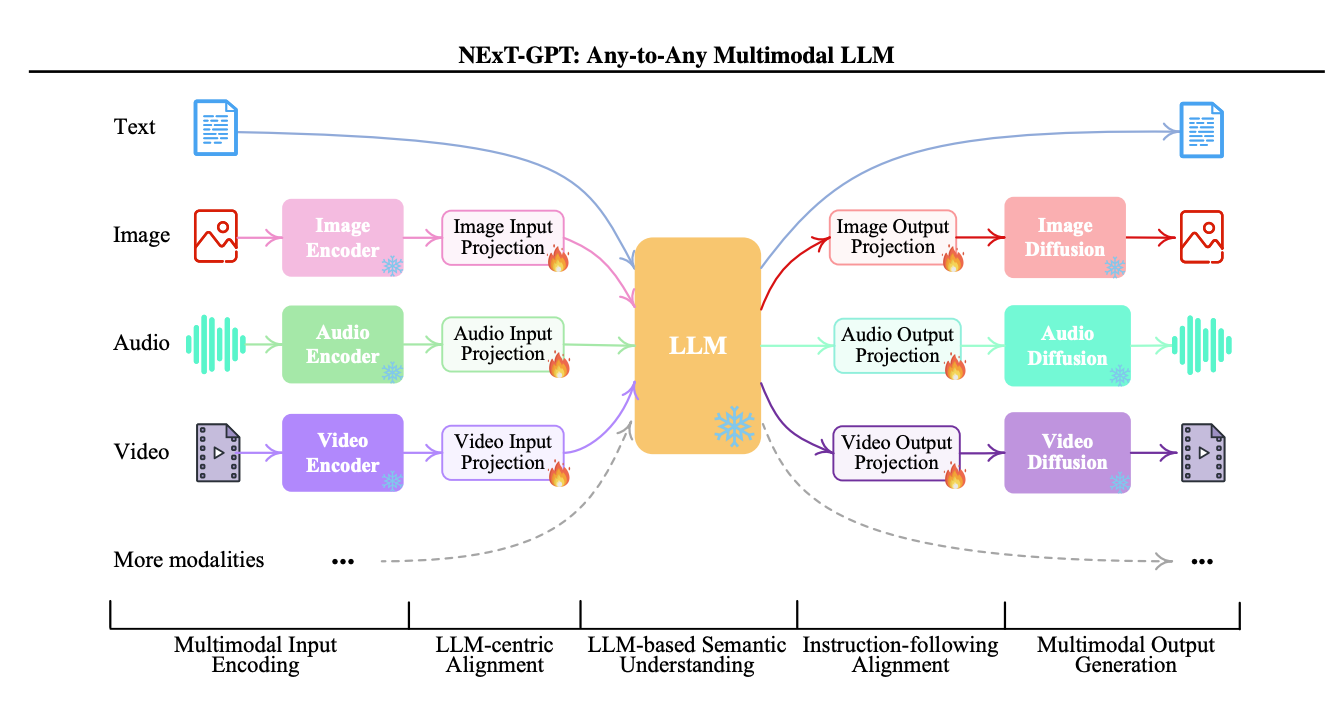

Next GPT 예시

+++

인코더를 지나면서 positional embedding, modality embedding이 추가적으로 이뤄집니다.

- positional embedding은 각 토큰의 위치를 의미하고

- modality embedding은 각 토큰이 어떤 modailty인지(텍스트, 이미지, 영상) 알려줌

용어 공부

- 사전 학습 (pre-train)

- 모델을 처음부터 학습하는 것을 의미합니다.

- 일반적으로 모든 학습 단계 중에서 가장 많은 시간과 자원을 소모합니다.

- 사전 학습이 많은 자원을 필요로 하는 특성 때문에 소수만이 경험할 수 있는 기술이 되어서 몸값이 높아졌다고 합니다...!

- 파인 튜닝 (fine-tuning)

- 사전 학습이 끝난 모델을 추가로 학습하는 것을 의미합니다.

- 비교적 적은 자원을 소모합니다.

- 사후 학습 (post-train)

- 파인 튜닝과 동일한 의미를 가지고 있지만 업계에서는 모델 제공 업체가 수행하면 사후 학습, 사용자가 수행하면 파인튜닝이라고 한다네요.

- 데이터셋 엔지니어링 (dataset engineering)

- AI 모델의 학습과 조정에 필요한 데이터를 선별하고, 생성하고, 주석을 작성하는 작업을 의미합니다.

- 추론 최적화 (inference optimization)

- 파운데이션 모델들이 AR 기반이다보니 토큰이 순차적으로 생성되어 시간이 오래 걸리는 문제가 있습니다.

- 이를 해결하기 위해 양자화, 증류, 병렬화 등의 기법을 사용한다고 합니다.

'For Fun > 잡학 지식' 카테고리의 다른 글

| AI 엔지니어링 스터디 #3 - AI 서비스 개발하기 전 체크리스트 (0) | 2026.02.03 |

|---|---|

| 코드 컨벤션, 아키텍처도 잘 지키고 있는지 테스트 케이스를 만들 수 있습니다! – ArchUnit vs Konsist (3) | 2026.01.12 |

| AI 엔지니어링 스터디 #1 - Anthropic이 알려주는 컨텍스트 엔지니어링 (2) | 2026.01.10 |

| 검색 맛보기 (0) | 2025.12.13 |

| 이커머스 앱 페이지 용어 공부하기 - 커머스 도메인 이해하기 #4 (2) | 2025.11.03 |